Mientras la inteligencia artificial nos supera, tendremos que vivir con sus tonterías

Las máquinas son tontas… por ahora. En lo que eso nos da algo de ventaja frente a ellas, en realidad, estaremos a merced de sus malas decisiones.

Todos hemos aplicado la palabra “estúpida” a las impresoras (con frecuencia, usamos peores palabras). Insultos parecidos le decimos a nuestra computadora personal si no está procesando a la velocidad que quisiéramos. No digamos los asistentes de voz, que están medio sordos, entienden todo mal, o dan indicaciones absurdas.

Podrá sonar contradictorio, pero para fortuna nuestra, las máquinas siguen siendo bastante idiotas. Al menos por ahora.

Pero poco a poco —auguran los profetas de la tecnología— las máquinas se irán volviendo más inteligentes. Incluso, de una inteligencia superior a la nuestra, de manera que gradualmente nos irán suplantando. ¿Suena a una mala noticia? Hay una peor: en lo que nos desplazan, mientras no lleguen a ser tan listas como para ocupar nuestro puesto de trabajo de modo eficiente, tendremos que aguantar sus cada vez más peligrosas estupideces.

Así lo reportó la revista Wired, que transcribió las advertencias de Alphabet (la empresa propietaria de Google), y de Microsoft, a sus inversionistas. En ambos casos, y en lenguaje legal indicaban (un poco para curarse en salud) que la inteligencia artificial no era perfecta y que podría dar lugar a todo tipo de escenarios desagradables, que pueden derivar en conflictos éticos, humanos o tecnológicos.

Esos algoritmos que no entienden nada

Estas advertencias hacen eco de casos recientes en donde la tecnología ha sido peligrosamente estúpida. Algunos son anecdóticos y solamente ofensivos: por ejemplo, el algoritmo de reconocimiento de rostros de Google no es capaz de distinguir entre una persona de raza africana de un gorila. Si bien imperdonables, no son graves en comparación a los que han ocasionado muertes: los programas que conducen vehículos autónomos ya ha han cobrado una decena de víctimas por accidentes viales. Y ni qué decir de los casos de accidentes aéreos provocados por errores en la computadora de vuelo donde las víctimas mortales se cuentan por centenares.

El problema, por ahora, es que ese tipo de inconvenientes trágicos lejos de reducirse conforme las máquinas van aprendiendo funciones cada vez más complejas, tenderán a aumentar conforme les cedamos más y más responsabilidades. Tal vez llegue el día en el que finalmente sean casi infalibles, o eso se supone; pero mientras tanto, es posible que causen suficiente caos y destrucción como para que queramos cancelar su desarrollo.

Un artículo publicado en diciembre pasado de un equipo de psicólogos cognitivos de la Universidad de Los Ángeles (UCLA) se enfocó en la manera en que las máquinas “miran” a los objetos. Así lo explican: “En los seres humanos, la forma es la clave más importante al momento de reconocer objetos. Estudiamos si las redes neurales profundas, entrenadas en reconocer objetos, hacen uso de la forma.” Sus hallazgos parecen indicar que las máquinas inteligentes se guían por otro tipo de señales como la textura en la superficie y que de hecho son particularmente insensibles a la forma de las cosas. La conclusión, como la expresó el profesor Hongjing Lu, uno de los coautores del estudio al sitio Phys.org, es que todavía es muy fácil engañar a los ojos de las máquinas, y que sus mecanismos de aprendizaje siguen siendo mucho menos sofisticados que la mente humana. Por ejemplo, el ojo humano —y el animal— entiende una forma y la procesa. Las máquinas, literalmente, aún se clavan en la textura.

Y el robot va al psicólogo

Lo más inquietante del estudio no es el resultado, sino la metodología: se le mostraban a los programas de visión formas con texturas que no correspondían (la textura de una pelota de golf en una tetera, o un camello con rayas de zebra) y ésta no atinaba a reconocer el objeto correctamente. Peor aún, el estudio no lo hicieron ingenieros, sino psicólogos.

Cuando un programa es sencillo, y hecho por seres humanos, se estudian las líneas de programación en sí para poder determinar dónde está la falla. Por otro lado, a una persona con problemas en la vista se le presentan una serie de figuras para que las identifique, y de ahí se determina si necesita anteojos o no.

Ahora se está estudiando a las creaciones humanas como entidades independientes a pesar de haber sido inventos del ser humano. Lejos de estudiar el programa de instrucciones que las gobierna, ahora deben ser sometidas a pruebas externas, psicológicas, para tratar de dilucidar cómo es que “piensan”. Ya no se estudia el programa en sí porque ya es ininteligible, generado por la propia máquina y solamente interpretable por ella misma.

El ser humano también aprende de prueba y error: hoy se cae un avión, muere un centenar de personas y mañana se corrige el desperfecto. Si no se aprendiera de modo tan doloroso, los aviones no serían, a pesar de accidentes tan notables, uno de los medios de transporte más seguros del mundo. Lo mismo pasará con los autos autónomos. El precio del progreso a veces parece demasiado alto.

Sigue leyendo sobre los cobots.

Felipe Soto Viterbo (Twitter: @felpas) es novelista, editor, consultor narrativo para Vixin Media y director de Etla, despacho de narrativa estratégica.

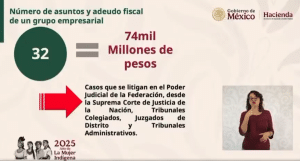

Suscríbete a El Fiscoanalista (novedades y jurisprudencias en materia fiscal y laboral) y a nuestro canal de YouTube.